Open data: bug e bugfix.

Se lancio una palla, da una parte, dall'altra per condurre un gioco secondo determinate regole ci deve essere qualcuno a raccoglierla, altrimenti il gesto perde di senso. È questo uno dei compiti degli open data: da una parte decentralizzare il potere, togliendolo dalle mani e dai cassetti di chi prima faceva del dato raw una merce di scambio per favori molto spesso personali. Il secondo compito, tuttavia, è quello come ho già detto in passato di stimolare gli hacker civici e la popolazione in generale a produrre valore aggiunto rispetto a questi dataset, attivando un meccanismo virtuoso che parte dal bit, e impatta sullo stile di vita della popolazione circostante.

Durante Green Open Data, poco prima della presentazione di TweetYourMEP, ci siamo imbattuti in qualcosa a cui onestamente io avevo già pensato, ma era qualcosa a cui non avevo osato dar sfogo: c'è stato chi l'ha fatto prima di me, chiedendo se non sia possibile stimolare le amministrazioni a produrre e liberare una serie di dataset "predefiniti", a beneficio degli hacker interessati all'uso di questi dati. Le risposte sono state molto vaghe, e la più soddisfacente in buona sostanza recitava: "partiamo con le cose facili, perché obbligare un'amministrazione a fare questo vuol dire complicare lo scenario, e mettere i bastoni tra le ruote a chi vuole semplicemente liberare i propri dati".

Penso conosciate tutti Yoda. È la figura che in Star Wars esemplifica ed incarna la saggezza suprema, colui che grazie all'esperienza di una vita molto lunga, ha accumulato un bagaglio culturale tale da fare sempre la scelta giusta. Ne L'Impero Colpisce Ancora, Yoda si esibisce in una meravigliosa considerazione di stampo quasi taoista: "Do, or do not. There's no try." - sostanzialmente possiamo usare questa citazione per un grosso numero di esempi. Gli open data fanno al caso nostro per raccogliere la riflessione di Yoda: dobbiamo fare. Lo spazio per i tentativi è rimasto a zero, in una condizione come quella attuale, e per quanto la tematica sia calcata con passo incerto dalle amministrazioni, dobbiamo ammettere che è tardi per far rimanere gli open data un tema di nicchia ma non solo: qualcosa a cui gli sviluppatori credono e non credono.

Ad oggi infatti il viaggio di uno sviluppatore all'interno del panorama open data è pieno di incertezza: speriamo di trovare quel dataset, e speriamo di trovare le informazioni che mi servono. O al contrario, che figa questa informazione, adesso ci faccio un'applicazione ma, attenzione, speriamo per allargare il mio raggio d'azione che altre amministrazioni rendano disponibili dati dello stesso tipo. È tutto molto difficoltoso, e come detto da alcuni non è interessante in termini di ore/uomo che qualcuno sviluppi applicazioni su un modello così frammentato dove regna il caos più totale. Uno dei rischi di questo approccio per esempio è che arrivi Alfonso Fuggetta, e venga a dire che tutto quello che stiamo costruendo non funziona. È vero: non funziona. Ma diciamo (e lo dico da sistemista Linux, quindi avrei tutto l'interesse di dire il contrario) che molto del problema risiede nella prassi. Attraverso servizi come Singly possiamo facilmente costruire API che reggano il confronto con quelle di database ben più professionali. Con dei dataset così frammentati tuttavia è necessario uniformare l'esperienza di fruizione da parte del programmatore, rendendogli più facile la vita. In che modo?

- Stilare - e c'è chi ci sta già provando - un elenco di dataset che presumibilmente dovrebbero trovarsi in ogni amministrazione, o quantomeno che sarebbe buona creanza avere

- Effettuare un packaging di questi dati in una maniera universale (JSON può essere un modo) e interoperabile

- Aprire il dato avendo cura di aderire ad uno standard di nomenclatura in modo da consentirne un facile riuso e l'inclusione in algoritmi di ricerca per la creazione di API efficaci

Una volta messi in pratica questi tre punti, avremo una mole di conoscenza fruibile dagli hacker civici in maniera uniforme, ed un parco di potenziali applicativi molto più d'impatto del "greppatore di pini andati a fuoco durante l'incendio a Rocca Cannuccia".

Bisogna smetterla di cercare scuse, e attivarsi affinché la rivoluzione del dato aperto trovi corrispondenza d'amorosi sensi (scusa Ugo per la citazione aggratise) proprio nella popolazione e presso ulteriori, potenziali hacker civici.

There's no try.

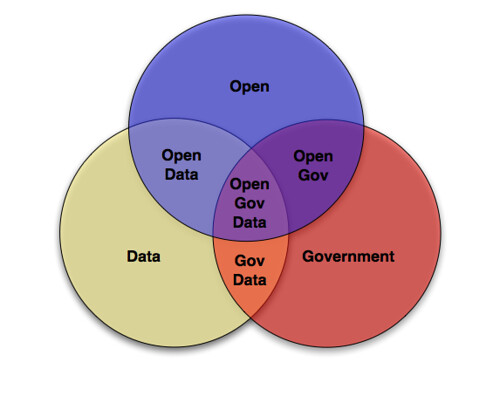

Image courtesy of Justin Grimes